Institution

CISPA Helmholtz-Zentrum für Informationssicherheit, Saarbrücken

Forschungsthema

Individualisierte Privatsphäre im Maschinellen Lernen

Forschung im Detail

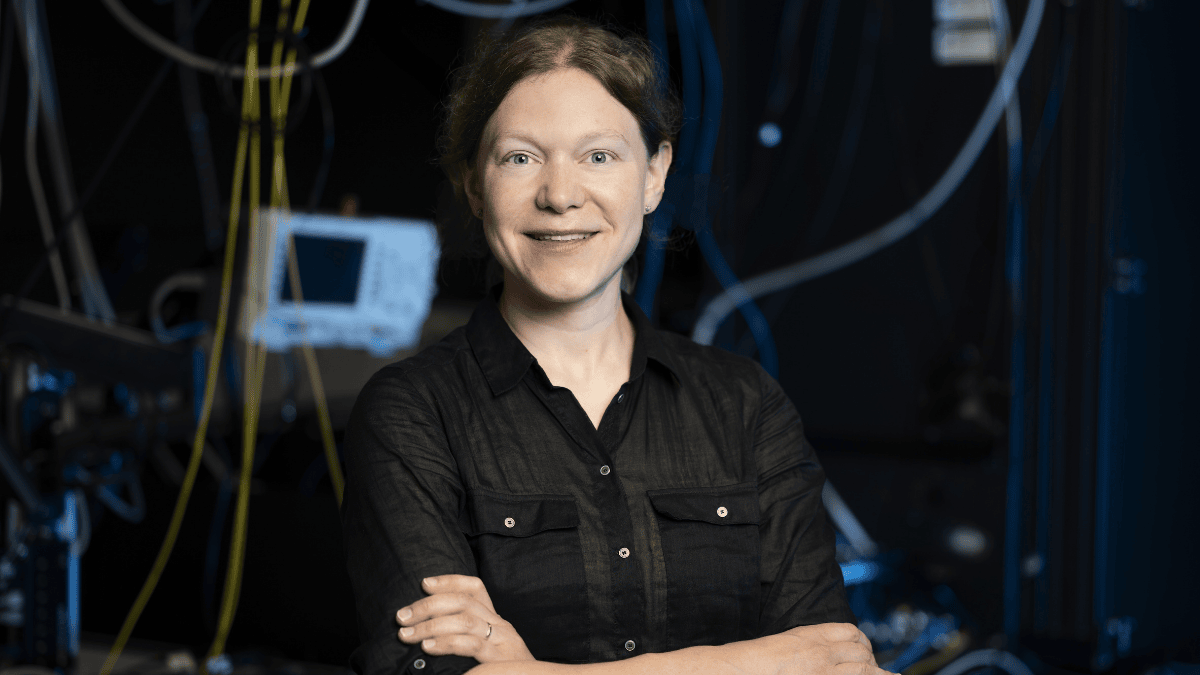

Wie kann unsere Gesellschaft die Chancen Künstlicher Intelligenz nutzen, ohne sensible Daten zu gefährden? Diese Frage steht im Zentrum der Forschung von Franziska Boenisch. Ihre Arbeit bewegt sich im Spannungsfeld von Datenschutz, Nutzerautonomie und Modellqualität. Sie entwickelt neue Ansätze für sogenannte Differential Privacy, die den Datenschutz nicht als starres, pauschales Maß behandeln, sondern individuell auf die Bedürfnisse der Nutzer:innen abstimmen.

Boenisch hat ein Konzept geschaffen, das es erlaubt, persönliche Datenschutzpräferenzen direkt in den Trainingsprozess von KI-Modellen einzubeziehen – etwa bei Sprachmodellen im Gesundheitswesen. Damit können Patient:innen künftig selbst bestimmen, welche Daten wie stark anonymisiert oder gar nicht verwendet werden. Gleichzeitig bleiben die Modelle leistungsfähig und aussagekräftig.

Der praktische Mehrwert: KI-Anwendungen lassen sich gezielter, ethisch verantwortungsvoll und nutzerzentriert einsetzen. Die Kombination aus technischer Exzellenz und gesellschaftlichem Nutzen macht ihre Arbeit wegweisend für eine menschenorientierte KI-Zukunft.

Kurzbiografie

Franziska Boenisch (31), lebt in Saarbrücken und ist Tenure-Track-Faculty am CISPA Helmholtz-Zentrum für Informationssicherheit, wo sie das SprintML Lab mit aufbaut. Sie hat Informatik an der Freien Universität Berlin studiert, war als Postdoc am Vector Institute in Toronto tätig und hat umfangreiche internationale Forschungserfahrung – unter anderem in Taiwan, Kanada und den Niederlanden. Für ihre Dissertation zur sicheren und privaten KI wurde sie mehrfach ausgezeichnet, unter anderem mit dem Fraunhofer IuK-Dissertationspreis.